美国专利及商标局日前正式公布了苹果68项新专利,据了解到苹果获取了一项跟沉浸式增强现实有关的重要专利,其有可能作用于未来的iMac,iDevice和头显设备。苹果执行总监库克已经不止一次谈到苹果对增强现实技术的兴趣,他此前在接受ABC News采访时曾谈到增强现实允许人们相互之间的交流更具临在感和分享性,这让AR更具有商业可行性。库克的言论给我们描述了一个沉浸式增强现实的苹果愿景。

苹果新授予的专利涉及通过摄像头阵列捕获场景图像,基于观看者视点(POV)处理捕获图像的操作、系统和计算机可读介质,而这主要是用于沉浸式增强现实、实况显示墙、头戴式显示器、视频会议和相关应用。

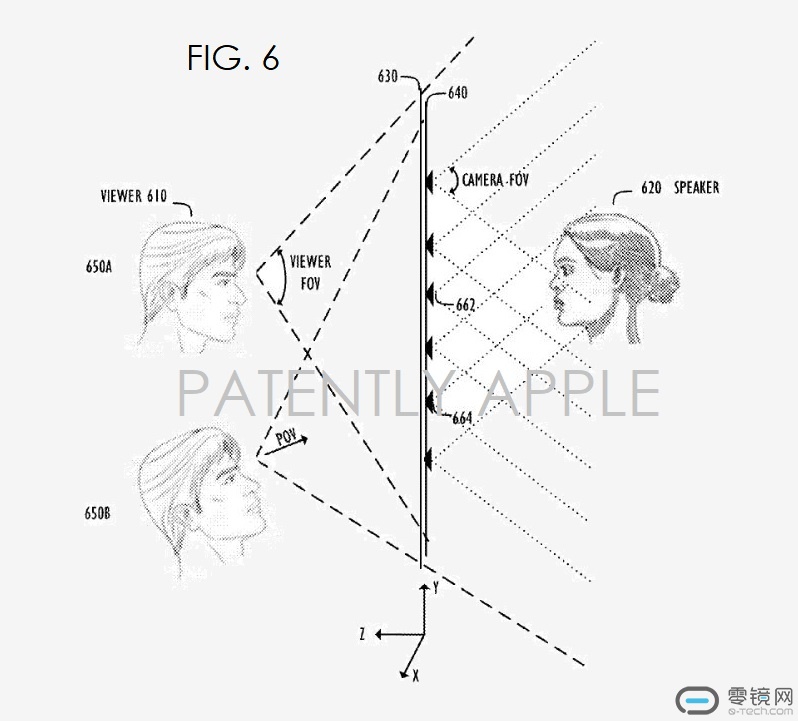

苹果的发明描述了一种与沉浸式增强现实、实时显示墙、头戴式显示器和视频会议应用程序相关并可用于图像捕捉和处理的技术。在一个实施例中,苹果描述的系统通过由摄像机阵列捕获的图像向观看者提供完整的视图。在另一个实施例中,随着观看者从一个位置移动到另一个位置,苹果所描述的发明可以追踪观看者的视点,并且根据视点变化显示图像。观看者视点的变化包括X、Y和Z轴上的运动。

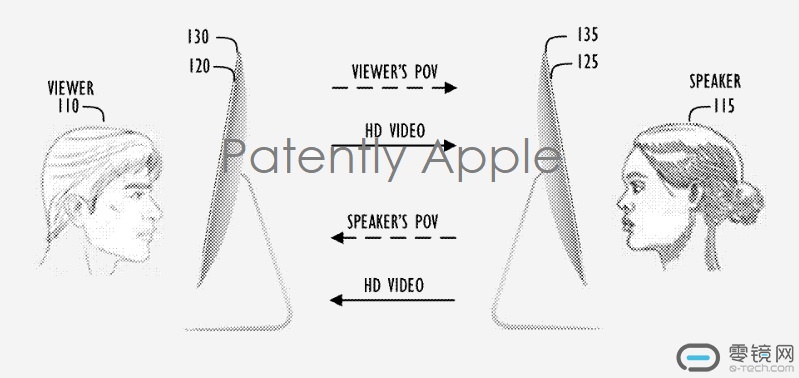

比如根据一个实施例,每位用户可以通过一个终端参与到视频会议中。每个终端包括显示器、摄像机阵列、图像处理单元(例如,包括硬件和/或软件)、以及网络连接(例如,通过缆线和/或无线连接)。每个摄像头阵列可以包括多个摄像头。

摄像头阵列可以捕获图像(如颜色RGB、YUV和YCC等)。摄像机阵列也可以捕获深度,捕获信息以计算深度(如结构化光、飞行时间和立体图像等),或者以其他方式计算每位用户的深度,同时追踪该用户的视点(比如通过头部和/或眼睛位置呈现)。观看者视点数据可由终端发送,然后说话者终端可通过网络连接接收。

请注意,如以下专利图6所示,苹果在上下文中使用的术语“说话者”是指一个人,而不是音频扬声器。

苹果还指出:“说话者终端内的图像处理单元可以根据用户视点来处理说话者的捕获图像,特别是图像处理操作可包含通过基于用户视点的捕捉图像来修剪像素,以及识别剩余像素的剔除操作。剔除操作的目的是减少数据处理量,因为处理后的数据最终将从一方传输到另一方,因此剔除操作可减少传输数据量,节省带宽,降低延迟。

在剔除像素后,图像处理单元可以把来自各个摄像头三维空间的剩余像素映射到二维显示空间。接下来,映射像素的数据可以通过说话者终端发送,然后观众终端通过网络进行接收。接着,观众终端内的图像处理单元可以混合映射的像素并组合准备好显示的图像(即“帧”)。

另外,观看者终端可以借助说话者视点来处理观看者的捕获图像。观看者终端内的图像处理操作可以“映照”说话者终端内的处理。

苹果所使用的术语“说话者”和“观看者”在这里被用于解释所公开概念。在视频会议中,每一位用户都作为相对于他/她的说话者和观看者。因此,上文描述的说话者和观看者位置的图像捕获和处理操作都在每一个位置的终端内同时且连续进行。根据本方视点,这可以为每位用户提供对方的连续显示帧,亦即实时视频。

此外,摄像头阵列可以单独操作,或是在每个位置集成到显示器中。对于沉浸式增强现实、实况显示墙和头戴式显示器等可能只有一名观看者的应用中,终端之间可以出现不对称,只需捕获要显示在观看者屏幕的场景即可,同时观看者位置可以无需任何摄像头阵列。

观看者的视点可以由专用于追踪目的的一个或多个摄像头来进行追踪,又或者是使用与摄像头阵列分离的其它设备,与此同时可以不追踪说话者的视点。

总的来说,光场技术正在彻底改变我们在视频和静止图像中观看图像的方式。现在的iPhone 7 Plus已经可以让用户在拍摄照片时选择人像模式。这种功能可以自动创建具有背景虚化效果的图像,也就是说位于图像最前端的人物或物体保持清晰,而背景图像则淡化模糊。

随着iPhone摄像头添加光场技术,用户在拍摄图像上可以更进一步。观看通过人像模式拍摄的图像的用户可能会不同,因此在拍摄完图像后用户可以对图像中的另一个对象进行重新聚焦。

这一点令人感到十分兴奋,因为光场技术可以帮助未来iMac实现超先进的FaceTime通话,同时也能应用于iDevice和头显一体机等设备上。

专利号为9,681,096的苹果专利最初于2016年Q3季度提交,并由美国专利及商标局于日前正式公布。

横排-无底-140x48mm-04-1.png)

竖排-无底白字-280x96mm-04.png)